Los deepfakes son imágenes o videos falsos hiperrealistas, generados o manipulados por inteligencia artificial (IA), en los que personas (no) existentes parecen hacer y decir cosas que nunca han hecho. El University College London [1] ha clasificado a las falsificaciones profundas como la amenaza delictiva de IA más grave. Junto con la accesibilidad cada vez mayor de la tecnología deepfake y la velocidad de las plataformas de Internet, los deepfakes convincentes pueden llegar rápidamente a millones de personas y tener un impacto devastador en nuestra sociedad. ¿Por qué? Piense, por ejemplo, en la entrega de pruebas falsas a los tribunales, marionetas falsas [2], chantaje, terrorismo o noticias falsas en las que figuras políticas de confianza difunden información falsa que provoca trastornos sociales.

Generación profunda falsa

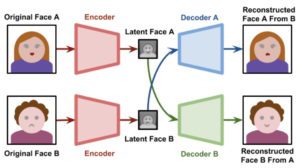

Deepfakes se ha vuelto popular debido a la facilidad de uso de sus aplicaciones para una amplia gama de usuarios con o sin conocimientos informáticos. Para ello se han aplicado técnicas de aprendizaje profundo representando datos complejos y de alta dimensionalidad. La primera instancia de generación de deepfake, es decir, FakeApp, fue desarrollada por un usuario de Reddit que implementó una estructura de emparejamiento de codificador-decodificador automático [3]. Este método utiliza un codificador automático que extrae los elementos latentes de las imágenes de rostros y un decodificador que reconstruye las imágenes de rostros. Para intercambiar caras de dos imágenes de destino, se necesitan dos pares de codificador-decodificador con el mismo codificador.

Figura 1: generación de un deepfake usando el binomio autocodificador-decodificador [4]

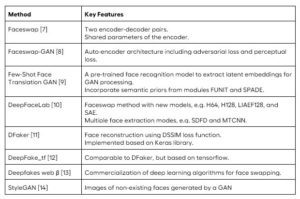

Al implementar la pérdida antagónica y la pérdida perceptual en la arquitectura de codificador-decodificador de VGGFace, se considera una versión mejorada de deepfakes basada en la red antagónica generativa (GAN) [5]. La pérdida de percepción de VGGFace mejora la creación de deepfakes de manera que los movimientos de los ojos parecen más realistas y consistentes con las caras de entrada. Además, contribuya a suavizar los artefactos, lo que da como resultado imágenes de salida de mayor calidad. Para hacer que la detección de rostros y la alineación de rostros sean más estables, se presenta la red neuronal convolucional multitarea (CNN) de la implementación de FaceNet [6]. Los métodos notables de generación de deepfakes se resumen en la tabla 1.

Tabla 1: métodos de generación de deepfake ampliamente utilizados [7]

Aplicaciones maliciosas de deepfakes e intervenciones gubernamentales

El primer video deepfake surgió en 2017 en el que se cambiaba la cara de una celebridad por la de un actor porno [7]. Desde entonces, la tecnología se ha utilizado para influir en la opinión pública. Un ejemplo es la periodista Rana Ayyub. Su rostro se transformó en un video pornográfico como si hubiera actuado en él. Este ataque virulento se produjo poco después de que hiciera campaña por justicia para la víctima de violación de Kathua. Deepfakes también podría servir como incentivos personales maliciosos. Una madre de Pensilvania supuestamente usó videos falsos explícitos para intentar que las porristas rivales de su hija adolescente fueran expulsadas del equipo [15].

El caso del ministro de asuntos económicos de Malasia, Azmin Ali, es notable para analizar. En 2019, Azmin estuvo involucrado en un escándalo de video sexual en el que supuestamente tuvo relaciones sexuales con un miembro de su partido político, Haziq Abdul Aziz [16]. Dado que la sodomía es un delito en Malasia, que conlleva hasta 20 años de prisión [17; 18], Azmin trató de evadir las consecuencias alegando que el video era un deepfake. Aunque nadie ha podido determinar definitivamente lo contrario, la opinión pública y la de los expertos en forense digital, entre otros, se han mantenido divididas [19; 20]. Dado que el público no puede distinguir entre qué información es real o falsa, está más dispuesto a adoptar sus sesgos predeterminados [21].

Como resultado, esto tuvo consecuencias devastadoras para la reputación y la carrera política de las partes involucradas. Además, esto ha llevado a una desestabilización de la coalición gobernante y un rechazo enfático a los derechos LGBT en Malasia [22; 18]. Según Towes [21], los deepfakes no solo deterioran las divisiones sociales y perturban el discurso democrático, sino que también socavan la seguridad pública y debilitan el periodismo.

Por lo tanto, los gobiernos y las fuerzas del orden de todo el mundo están tomando medidas para prevenir este problema. Invertir en soluciones tecnológicas que puedan detectar deepfakes y desarrollar una legislación apropiada para castigar a los productores y distribuidores de deepfakes son dos de las acciones más propuestas por el gobierno [20]. Según Welch [23], una mejor identificación de las falsificaciones profundas no solo ayudaría a proteger el derecho de expresión de las personas sin permitir la distribución de contenido dañino, sino que también ayudaría a las plataformas de redes sociales a mejorar sus políticas sobre las falsificaciones profundas. Además, la legislación adecuada hace que sea ilegal distribuir deepfakes con intenciones maliciosas y crear recursos para aquellos que se han visto afectados negativamente [24].

Detección de falsificación profunda

Pero, ¿cómo podría el sistema de justicia actuar sobre falsificaciones profundas realistas y proteger a nuestra sociedad cuando las fronteras entre imágenes digitales reales y falsas se están desvaneciendo cada vez más?

Mandet 2.0 incluye un filtro de detección de deepfake que no solo clasifica si una imagen es deepfake o real, sino que también explica el razonamiento detrás de su clasificación. El componente principal de este filtro de detección de falsificaciones profundas, es decir, la detección de falsificaciones profundas, es DeepDetector. DeepDetector es una red neuronal que toma una fotografía de una persona como entrada y analiza el rostro en busca de alteraciones. Posteriormente, DeepDetector genera la probabilidad de que una cara específica haya sido alterada o generada por la tecnología deepfake.

DeepDetector fue desarrollado por DuckDuckGoose [25] inspirado en los avances recientes en el campo de la generación y detección de deepfakes [26].

Resaltando artefactos deepfake

Hay muchos tipos diferentes de técnicas para generar deepfakes. Estas técnicas de generación de deepfakes dejan “artefactos” en imágenes o videos. Estos artefactos son el resultado de muchos algoritmos de edición o generación de rostros que exhiben artefactos, que se asemejan a los problemas clásicos de visión por computadora que se derivan del seguimiento y la edición de rostros [27]. Estas imperfecciones nos permiten distinguir el material real del ultrafalso. Los artefactos deepfake pueden incluir rasgos faciales poco realistas o transiciones incoherentes entre fotogramas.

DeepDetector fue desarrollado por DuckDuckGoose [25] inspirado en los avances recientes en el campo de la generación y detección de deepfakes [26].

Resaltando artefactos deepfake

Sin embargo, las técnicas actuales de generación de deepfakes son tan buenas que las caras generadas o manipuladas parecen cada vez más realistas. Esto da como resultado artefactos que son muy difíciles de detectar a simple vista. Un ejemplo de tal artefacto es la luz reflejada en los ojos. El reflejo de los dos ojos en una imagen de una cara real será similar ya que los ojos miran lo mismo. Sin embargo, las imágenes deepfake sintetizadas por GAN no capturan con precisión esta semejanza y, a menudo, presentan inconsistencias. Ejemplos de estos contienen diferentes formas geométricas o ubicaciones no coincidentes de los reflejos.

DeepDetector aprovecha el poder de las redes neuronales artificiales para distinguir entre imágenes reales y falsas. Para lograr esto, DeepDetector señala la ubicación de los artefactos introducidos por el deepfake. Esto se hace en forma de un mapa de activación basado en la entrada, dando una puntuación por píxel que permite al usuario del sistema tener una idea de dónde dejó los artefactos el deepfake.

Figura 2: aspectos destacados generados por el filtro de detección de DeepFake en Mandet 2.0 para detectar un deepfake

Conclusión

La tecnología deepfake es una amenaza emergente para la estabilidad gubernamental. No obstante, hay buenas noticias; el infocalypse deepfake puede ser mitigado. La tecnología de IA no solo es aplicable para crear deepfakes, sino que también se puede usar para reconocer esos deepfakes. Aunque se sabe que los sistemas de IA funcionan como una caja negra, DeepDetector integrado en Mandet 2.0 genera resultados explicables que brindan información sobre el razonamiento detrás de la clasificación binaria de esta red neuronal para la detección de falsificaciones profundas. De esta manera, los examinadores forenses podrían detectar deepfakes, sin tener que depender completamente de un sistema de IA, sino utilizando su experiencia para anticipar los resultados generados por DeepDetector en Mandet 2.0.

Revisa este artículo y sus referencias en foclar.com